Dans les innovations considérées comme promises à révolutionner notre Monde, l’intelligence artificielle est classée souvent en tête de liste. Qu’il s’agisse de Deloitte, de Bloomberg, ou bien de nombreux autres cabinets d’analyse ou de médias, l’intelligence artificielle est considérée comme la technologie disruptive du moment.

Dans les innovations considérées comme promises à révolutionner notre Monde, l’intelligence artificielle est classée souvent en tête de liste. Qu’il s’agisse de Deloitte, de Bloomberg, ou bien de nombreux autres cabinets d’analyse ou de médias, l’intelligence artificielle est considérée comme la technologie disruptive du moment.

Ainsi les laboratoires pharmaceutiques, GAFA et autres startups se sont engouffrés sur la brèche à travers des projets de décryptage du génome humain, de création de nouvelles molécules pour l’industrie pharmaceutiques, ou bien encore pour recruter des patients pour des essais cliniques, les exemples ne manquent pas…

Le monde pharmaceutique est loin d’être le seul et tous les secteurs semblent s’emparer dernièrement des technologies de l’intelligence artificielle pour mener des essais d’intégration dans leurs processus métiers.

Au moment où les intelligence artificielles ont battu les meilleurs joueurs de Go au Monde, où elles ont appris à jouer seules aux échecs, sans autre aide que les règles, et là encore, en quelques heures d’apprentissage préalable, battus les meilleurs, à l’heure où elles ont appris à se « reproduire« , où elles ont créé de nouvelles langues en discutant entre elles, et où elles ont, en seulement deux ans, atteint le QI de 47… A ce moment il est important de se demander quel est l’avenir de ces technologies dans les métiers de la veille et de l’intelligence économique.

L’intelligence artificielle et la veille

Avec le recul que je pense avoir sur le métier de meilleure de façon extrêmement pragmatique, j’identifie un ensemble de tâches plutôt chronophages et pas toutes extrêmement intéressantes pour lesquelles on est en droit (l’on se doit même) de se poser la question de l’utilité de l’intelligence artificielle pour remplacer l’être humain.

La traduction automatique

Dans les tâches utiles auxquelles le veilleur peut être amené à renoncer se trouve la traduction. Lorsque l’on surveille le web, les connaissances linguistiques se révèlent un réel atout. Si l’anglais semble être un impératif pour tout veilleur de part l’importance de la langue anglaise dans les publications scientifiques, business et plus généralement dans la masse d’informations publiées, les autres langues sont souvent difficiles à intégrer dans un processus de veille pour des raisons de compétences linguistiques et / ou de coûts.

Certes les outils de traduction automatique tels que Systran ou Google Translate, peuvent rendre service, ils ne parviendront pas a atteindre un certain degré de finesse de compréhension et ne permettront pas la traduction de documents pour des publications officielles « propres » sans passage par une traduction humaine. Google l’a d’ailleurs bien compris et propose à sa communauté d’utilisateurs de réaliser des traductions manuelles pour enrichir sa base de données de traduction à travers son site « community« . La complexité et la diversité des langues, de leur structures, nécessitent une programmation et / ou un entrainement spécifique pour les intelligences artificielles orientées traduction ce qui représentait jusqu’à présent un coût important.

Toutefois, l’investissement des acteurs majeurs du Web en ce domaine a permis une avancée colossale en termes de qualité de traduction à l’échelle planétaire. L’on notera ainsi que depuis août 2017 les traductions proposées par Facebook le sont entièrement par des intelligences artificielles, offrant par rapport au précédent système de traduction une amélioration de la qualité de la traduction de 11% en s’appuyant sur des réseaux neuronaux capables d’avoir une mémoire à court terme, de traiter des plus longues séances de mots dans leu ensemble, de se « débrouiller » avec les mots qu’elle ne connaît pas,…

Dernière innovation en date, la mise sur le marché d’une oreillette de traduction simultanée.

Le nettoyage et la structuration de l’information

Lorsqu’il parcourt une page web, un article de presse en ligne, l’oeil humain sait faire la différence entre ce qui correspond au texte de l’article et à tout le contenu périphérique. Il sait également extrêmement rapidement attribuer une date à l’article ainsi que son auteur lorsque ces dernières informations sont présentes.

Pour tout veilleur, l’incapacité des outils actuels à réaliser ces tâches élémentaires pour l’être humain se traduit par des tâches chronophage et peu intéressantes de vérification et de qualification des métas données, mais également des tâches de « nettoyage » de l’information. Qu’il s’agisse des bandeaux, des menus, ou de plus en plus des éléments polluants intégrés en milieu d’article, le veilleur perdra de longues minutes à mettre l’information au propre.

L’incapacité des outils (NDLR : de la plupart des outils, je ne citerai aucun nom) de veille à réaliser ces tâches pollue par ailleurs souvent le flux d’information. Lorsque la tache de « zonage » de l’information intéressante intervient trop tard dans le processus d’extraction et de filtre, les mots clés présents dans les zones périphériques (header, menu, footer, pubs, « A lire », A la une, etc) vont polluer le flux.

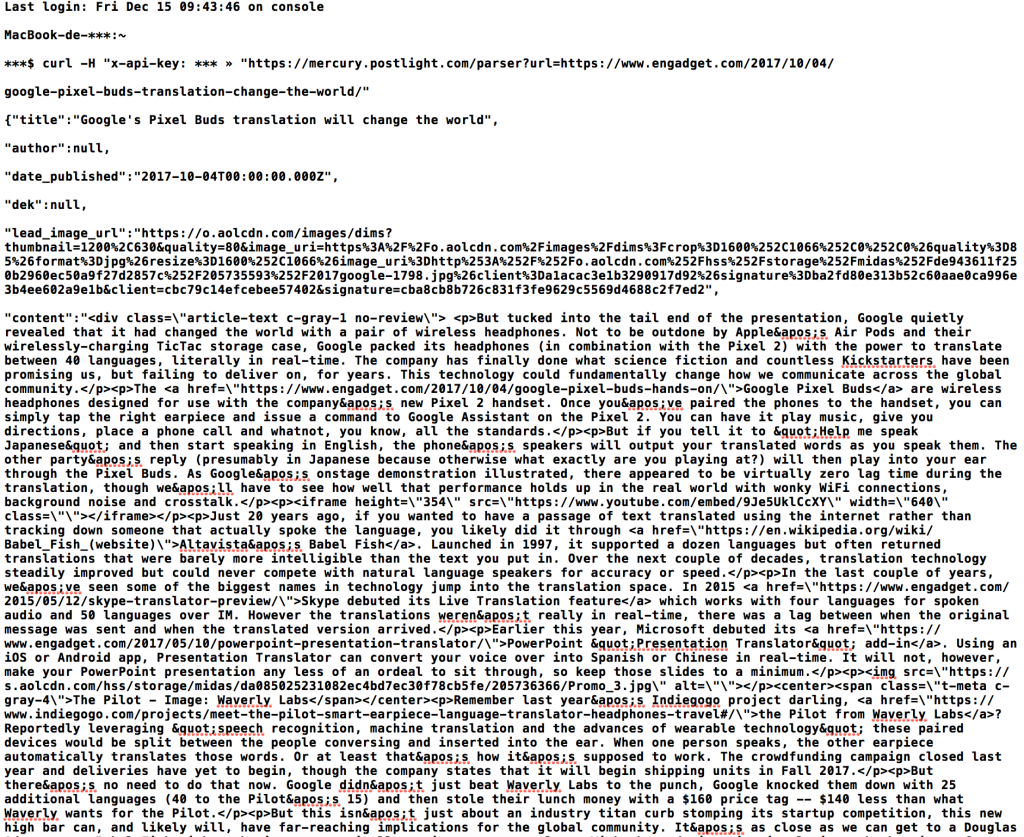

Les outils d’intelligence artificielle commencent à se pencher sur ces problématiques, Diffbot par exemple propose des API permettant ce genre de services (et l’on trouvera également l’API Mercury de Spotlight qui est recommandée par le défunt Readability, qui était un exemple en termes d’extraction d’article ciblé) mais, si ses performances sont intéressantes sur des articles de presse, elles restent moyennes sur des articles scientifiques en ligne par exemple. Par ailleurs ces outils d’intelligence artificielle reposent sans toujours le dire sur l’analyse du code, des templates et des « objets » à l’intérieur du code source des pages web. Sans connaissance ou apprentissage préalable du modèle ou des « objets », l’AI échouera souvent.

Ci-dessus le résultat de l’extraction automatique d’un article via l’API proposée par Mercury

A ce jour toutefois l’on note relativement peu (voire pas) de projets impliquant l’intelligence artificielle sur ce type de fonction et encore moins de solutions qui l’implémentent dans un processus complet de crawling, de structuration, de filtre et de publication.

La compréhension des constituantes d’une thématique

Dans les métiers de la veille, une des tâches fondamentales à traduire le besoin d’un client, face à un existant informationnel en ligne, en mots et en équation de recherche afin de capter toute l’information nécessaire et uniquement celle là.

Cela passe par une compréhension du sujet, de son champ lexical, par une confrontation à la réalité de la façon dont l’information est mise en ligne par les parties prenantes du sujet.

Inutile de dire que Google est celui qui semble avoir le plus penché sur ce sujet avec son algorithme « rank brain ». Le développement des assistants digitaux tels que Siri, Google Home, Alexa et consorts permet par ailleurs la construction conjointe de thésaurus évolutifs, contextualisés et personnalisés dont le but est de comprendre le langage y compris les questions. Les progrès réalisés le sont toutefois sur des tâches et de questions factuelles et opérationnelles et non pas sur la compréhension de lexiques liés à des domaines de savoir larges, aux frontières floues ou abstraits.

Si des progrès clairs sont déjà perçus entre l’émission par un chercheur / veilleur et la compréhension par sa machine, il reste encore un large travail humain pour construire l’ensemble de requêtes permettant de couvrir au mieux un domaine d’investigation.

La tonalité

Saint Graal du communicant, connaître les avis et opinions négatifs ou positifs sur un produit, une marque. Ne nous voulons pas la face, la technologie est assez mauvaise sur ce point. Ambiguïté du langage, ironie, élision de certains sujets, confusion évidente sur des secteurs d’activité dénotés négativement dans l’absolu (humanitaire, sa été par exemple), les algorithmes que moyennement efficaces pour vous dire si l’article est positif ou négatif en ce qui concerne votre sujet.

Certaines solutions de social media listening tel que Crimson Hexagon, en avance sur leurs concurrents avaient intégré le machine learning, proposant à l’utilisateur de qualifier à la main un certains nombres de messages afin de l’aider à « comprendre ». Aujourd’hui il faudra se trouver du côté des API du secteur du text analytics pour disposer des solutions les plus performantes telles que Semantria de Lexalytics.

Là encore, la marge de progrès est colossale…

La découverte de sources pertinentes

Chaque veiller connaît bien la tâche fondamentale de sourcing qui constitue à constituer un bouquets de sources produisant potentiellement des informations interessantes sur la thématique de surveillance définie. Dans l’idéal les veilleurs surveilleraient le web dans son entièreté mais à ce jour c’est Google qui se rapproche le plus d’une infrastructure capable d’indexer le web global et pour cela dispose d’une infrastructure colossale. Le veilleur et les éditeurs de logiciel de veille doivent bien se faire une raison, dans une processus de veille, le sourcing correspond à une étape fondamentale permettant de surveiller les sources prioritaires en corrélation direct avec des contraintes techniques et des contraintes de temps (de traitement de l’information).

Dans les éditeurs de logiciel de veille, c’est à ma connaissance IXXO (Web Mining) qui a le plus développé technologiquement une solution de crawl exploratoire, le logiciel partant de points de crawl prioritaires et crawlant les liens en profondeur (liens internes et externes) et permettant ainsi de découvrir des informations et donc également des sources en relation avec une thématique.

En dehors de cette solution logicielle, peu des acteurs du secteur proposent un réel module d’aide à la découverte de sources si ce n’est de proposer leurs propres packages de sources (reposant souvent sur un sourcing interne de l’éditeur mis en commun avec le sourcing réalisé par leurs clients) et un éventuel module « Google », le logiciel se reposant sur des requêtes envoyées au célèbre moteur de recherche afin d’identifier ses dernières actualités.

La marge de progrès est également colossale de ce point de vue là… En se reposant sur des sites tels que ReddIt, Twitter, Google News, ou tout autre outils de republication et de partage d’information, en couplant un crawler conditionnel et sémantique, en développant des outils de reconnaissance de zones textuelles intéressantes et de détection de dates performants, et enfin en ajoutant un module de machine learning voire d’intelligence artificielle pour apprendre avec l’utilisateur ce qu’est une source intéressante à intégrer au projet de veille, la fonctionnalité pourrait tout simplement être révolutionnaire pour nos métiers. Un périmètre de veille auto-apprenant qui détecterait et corrigerait les liens morts, apprendrait à ajuster ses paramétrages d’extraction et enfin proposerait l’ajout de sources semi-automatiques. Il n’est pas interdit de rêver.

L’avenir de nos métiers face à l’intelligence artificielle

A ce stade de l’état d’avancement des technologies d’intelligence artificielle, il me semble que le métier d’analyste est loin d’être remis en question. La capacité des intelligence artificielles à réaliser des synthèses de sujets complexes et parfois abstrait reste aujourd’hui limité mais reste limité aussi car l’être humain peine encore à modéliser et à formaliser le processus d’analyse intellectuelle qui repose sur des connaissances parfois diffuses, des perceptions inconscientes, et des processus de synthèse et de traitement de l’information complexes à mettre en équation.

Toutefois il me semble que le métier du veilleur et le positionnement « paramétrage / sélection / validation » peut être amené à se trouver dans une position délicate (encore plus délicate que celle d’aujourd’hui). Si aujourd’hui ce dernier est globalement sauvé par la précarité du business model des logiciels de veille dont le fonds de commerce est globalement incompatible avec un strict respect des droits d’auteur, les acteurs majeurs de l’information digitale ont redoublé leurs investissements ces dernières années pour développer des nouvelles technologies sémantiques et d’intelligence artificielle.

Enfin, je ne peux que militer pour que le métier du veilleur devienne soit plus technicien soit plus analyste.

Au cours de mes dernières années de travail j’ai constaté la forte numérisation et digitalisation des outils. Le processus était amorcé de longue date bien évidemment mais l’on voit à quel point ili s’est accéléré. Aujourd’hui il relève clairement des compétences clés de maîtriser certains fondamentaux liés à l’information digitale et à son accès : web mining, API, text mining, etc

Enfin, j’ai vu au fur et à mesure des ans s’appauvrir les effectifs de veilleur qui sont souvent devenus analystes, disposant d’une double compétence veille + sectorielle. Les veilleurs ont de plus en plus évolué vers des fonctions les amenant à (pré)analyser l’information et à en fournir une version qualifié, digérée, simplifiée, enrichie.

Et vous ? Quel est votre avis sur l’intelligence artificielle et son apport à nos métiers ? Quelles lectures intéressantes ou articles vous ont marqués ?

Crédits photos : Frédéric Martinet – Toute reproduction ou utilisation interdite sans accord préalable